1 - 11/03/2024

Una revisión sistemática sobre modelos de diagnóstico y predicción de infección de sitio operatorio usando herramientas de machine learning mostró un rendimiento aceptable. Sin embargo, estas herramientas carecen de validación externa y evidencia experimental de impacto clínico. Por tanto, antes de recomendar su implementación clínica se requiere consolidar un modelo de ML, incluyendo la gestión de fuentes de información y la evaluación de diferentes metodologías para avanzar en su validación.

Certeza en la evidencia: moderada por inconsistencia

Otros mensajes clave:

- La capacidad de clasificación de los algoritmos fue alta (área bajo la curva ROC ≥90%) independiente del tipo de datos y técnicas empleadas y la intencionalidad (diagnóstica versus predictiva).

- El rendimiento de los algoritmos de ML es mayor en su capacidad diagnóstica con relación a la predictiva.

Es importante saber lo que no se conoce:

- Se desconoce el impacto de la aplicación de los algoritmos en la práctica clínica diaria.

- Se desconoce la replicabilidad de los resultados de los modelos de ML fuera de los estudios, por falta de validación externa.

Antecedentes

Las infecciones de sitio operatorio (ISO) son complicaciones asociadas al cuidado de la salud derivadas de procedimientos quirúrgicos. Estos eventos ocurren hasta 30 días después de la cirugía (o hasta un año después en pacientes con implantes) y afectan la incisión, los tejidos profundos en el sitio de la operación o incluso órganos o espacios corporales (1). En la última década la incidencia global combinada acumulada de ISO (30 días del posoperatorio) en cirugía general fue de 11% (IC95% 10-13% I2= 99.7%) (2).

Se estima que las ISO están relacionadas con el 38% de las muertes en los pacientes que se identifica este evento; además, para 2017 representaron costos en la atención entre USD $174 y $34.000 (3). Así, la identificación de las ISO es esencial para el control y prevención de esta condición, no solo por la carga que la enfermedad representa para el paciente y los cuidadores, sino también por la carga a los sistemas de salud (4).

De acuerdo con los protocolos de vigilancia de ISO (5), el diagnóstico de estos casos puede hacerse por seguimiento activo y sistemático de pacientes, búsqueda rutinaria luego del reporte de algún signo de alarma en la historia clínica, o métodos de vigilancia post egreso (con la limitante de que no suceden en tiempo real). En todos los casos se requiere de entrenamiento del personal de salud para garantizar un registro exhaustivo (6). Algunas barreras para alcanzar un cubrimiento completo son la sobrecarga de los profesionales, la falta de estandarización de la definición y la forma de reporte, el registro incompleto de datos en las historias clínicas y una cultura organizacional que penalice, más que estimule, el reporte (7).

Los sistemas de vigilancia epidemiológica que se basan en registros administrativos, como los códigos CIE-10, tienen baja precisión en la estimación de estadísticas poblacionales (8–10), para ser depurados requieren alta inversión de recurso humano y tiempo (11).

La inteligencia artificial (IA) se define, desde una perspectiva amplia, como una tecnología que permite la imitación de las máquinas a diversas habilidades humanas complejas (12). Dentro del espectro de herramientas de IA, el Machine Learning (ML) puede proporcionar información sobre conjuntos grandes y complejos de datos en tiempo real lo que en este caso permite una identificación rápida y precisa de las tendencias de ISO y la detección de posibles brotes en curso (13).

Este Recado resume las capacidades operativas de los modelos de ML en la identificación y predicción de ISO dado su potencial impacto en la mejora de los resultados clínicos y la gestión de la atención en salud.

Información en la que se basa este Recado

La estrategia de búsqueda incluyó los términos “Surgical Wound Infection”, “Surgical Site Infection”, “Algorithms”, “Machine Learning”, “Artificial Intelligence”, “Natural Language Processing”, “Data Mining”, “Text Mining” y el filtro para revisiones sistemáticas (14) (Anexo 1, 2 y 3). Se construyó la estrategia para Medline/Pubmed y se adaptó para Embase, IEEE xplore. Se recuperaron 2 referencias relevantes (15,16) y se seleccionó la RS de Wu et al. (2022)(15) por su rigor metodológico.

Esta RS incluyó 47 estudios (32 para síntesis cualitativa y 15 para análisis cuantitativo) realizados principalmente en Asía, Europa y América, siendo la mayoría de los Estados Unidos. Los algoritmos fueron hechos a partir de datos textuales (9%), estructurados (43%) y mixtos (48%).

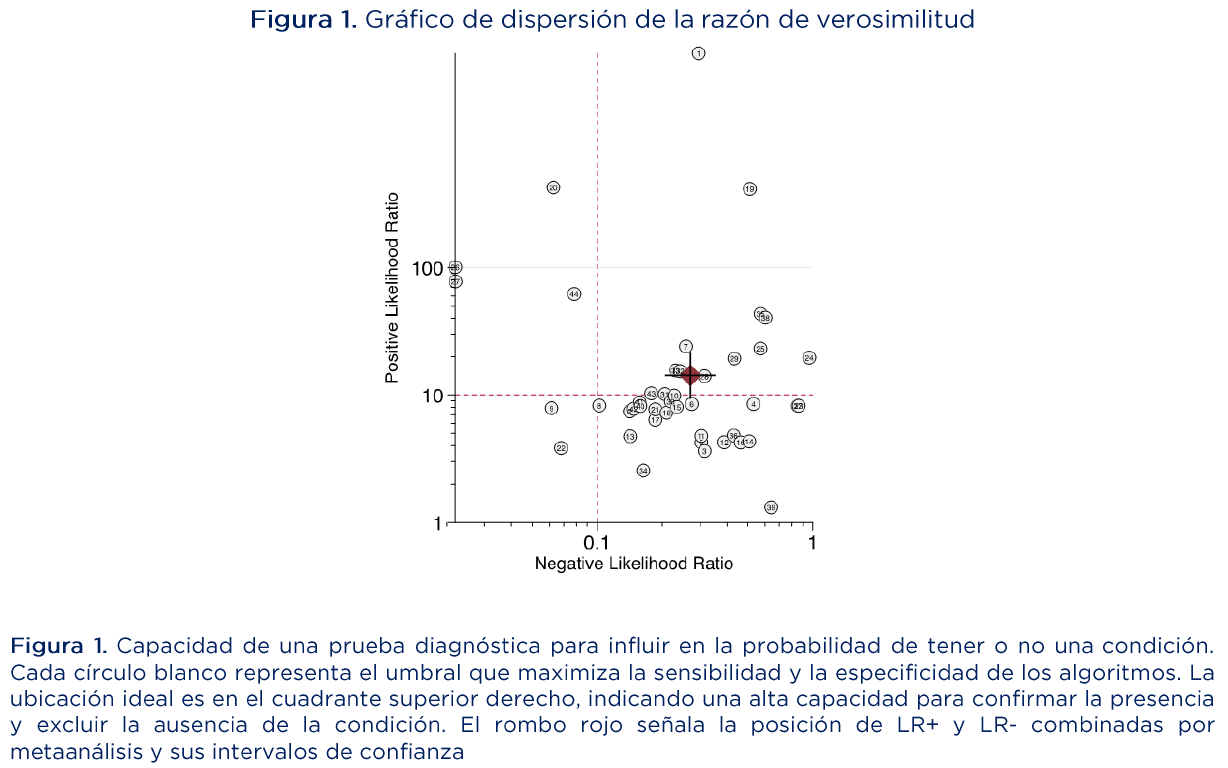

Para combinar la sensibilidad y especificidad de los diferentes estudios se presenta una curva de características operativas del receptor resumida (SROC por sus siglas en inglés) y la heterogeneidad se exploró con un modelo jerárquico de SROC (HSROC por sus siglas en inglés). Se graficó la razón de verosimilitud (Likelihood ratio – LR) para mostrar las aplicaciones potenciales de los algoritmos desarrollados. Los resultados informan medianas, rango intercuartílico (RIC) y área bajo la curva ROC.

En relación con el riesgo de sesgo de los estudios que nutrieron la RS, sus autores emplearon la herramienta QUADAS-2, concluyendo sobre los 32 artículos, que no se describió el proceso detallado de selección de pacientes en cuatro de ellos y nueve no especificaron claramente el estándar de referencia utilizado para la validación de algoritmos. Estos autores concluyeron baja probabilidad de sesgo de publicación.

Resultados

Los principales hallazgos de la RS fueron:

- El 53% de los artículos reportaron ISO a 30 días del posoperatorio con una incidencia de 6.076 eventos en 165.717 procedimientos quirúrgicos (3.7%, IC95% 6-3.8%).

- La distribución de los eventos a partir de cinco estudios fue de ISO incisional superficial (42.9%), ISO órgano/espacio (40%), e ISO incisional profunda (17.1%).

- Las intervenciones predominantes fueron mixtas (17.3%), colorrectales (5.2%) y gastrointestinales (5.2%).

- Se incluyeron seis artículos en población adulta, cuatro en pediátrica y veintiuno no especificaron la edad.

Se recuperaron 108 algoritmos de aprendizaje automático de los estudios (36 de modelos de detección y 72 de modelos de predicción), estos se desarrollaron utilizando regresión logística y su variante (31.3%), bosque aleatorio (13.1%), árbol de decisión (8.7%), máquinas de soporte vectorial (8.7%), y red bayesiana (7.6%). Los patrones de referencia utilizados incluyeron programas de vigilancia epidemiológica nacionales (8.2%), revisión de historias clínicas (8.2%) y programas de supervisión hospitalaria (5.2%).

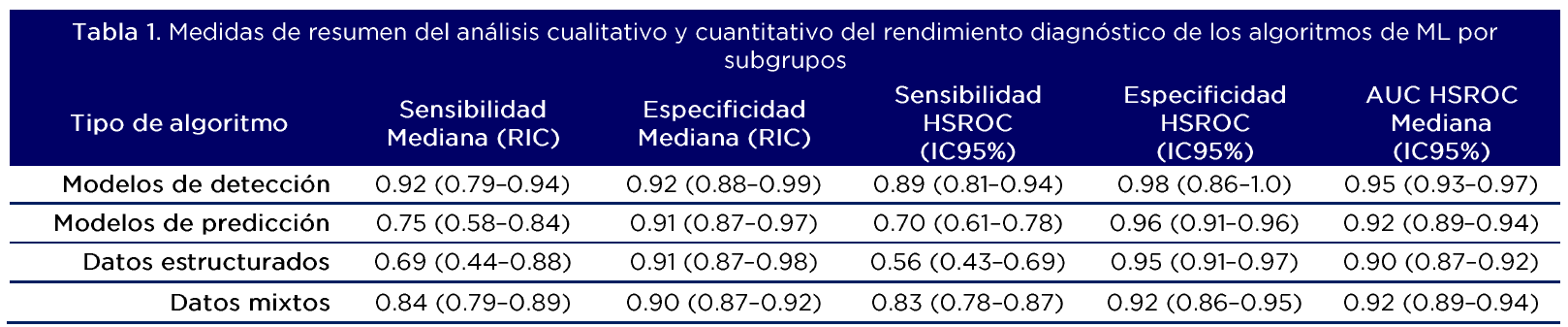

La tabla 1 resume los principales resultados del análisis por subgrupos, para cada modelo (detección/predicción) y tipo de fuente de dato utilizado (textual, estructurado, mixto). Los modelos de detección muestran mejores resultados de desempeño que los de predicción. La sensibilidad combinada se incrementa cuando se agregan los resultados provenientes de datos estructurados y de texto.

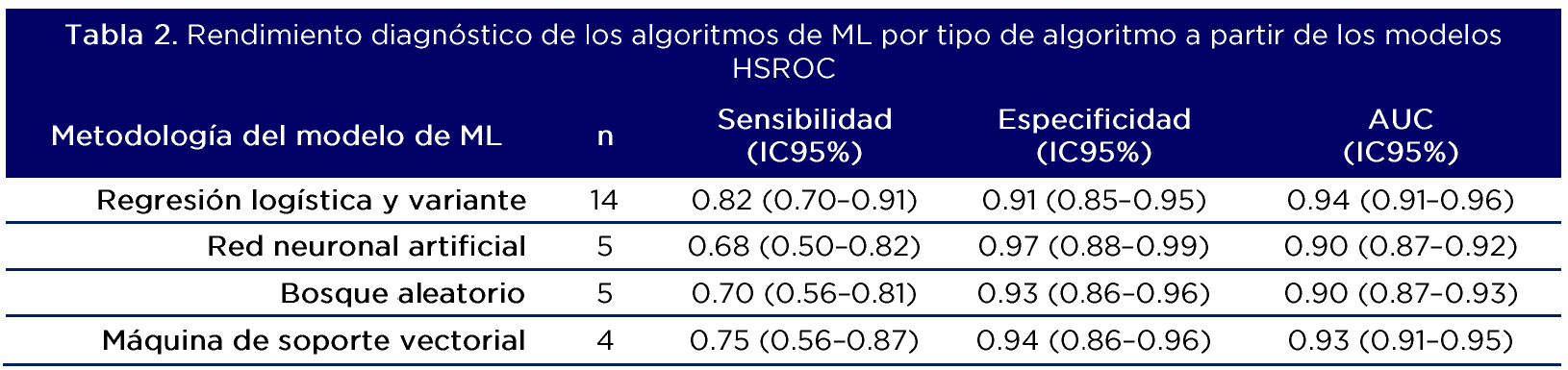

La tabla 2 resume los resultados por tipo de modelo de ML. Las mejores métricas de rendimiento diagnóstico y de clasificación fueron obtenidas a partir de modelos de regresión logística y variante.

El estimado agregado de los índices de LR+ y LR- indican que la prueba diagnostica tiene alta eficacia para identificar las ISO, demostrando tanto alta sensibilidad como especificidad (Figura 1)

Información sobre la evidencia que soporta este Recado

Luego de aplicar la herramienta AMSTAR-2 para RS (17) (Anexo 4) se concluye confianza alta. Aunque los autores aplicaron la herramienta QUADAS-2 no efectuaron una inferencia global sobre el riesgo de sesgo de los estudios agregados para metaanálisis. Por tanto, los autores de este Recado, consideramos que el riesgo de sesgo es bajo toda vez que el análisis de sensibilidad mostró similares resultados al no incluir los 4 estudios con alto riesgo de sesgo.

La certeza en la evidencia a partir de la metodología GRADE (18) (Anexo 5) se concluye moderada por inconsistencia que no fue explicada plenamente por la heterogeneidad clínica y metodológica (19).

Unidad de Síntesis y Transferencia de Conocimiento | Correspondencia: jvillarc@lacardio.org

Barragán AM*; Rodríguez, J*; Villar J**; Moreno, K**; Cruz, J**; Balcázar M**+

(*)Desarrollo, (**)Edición, (+)Diseminación

¿Tienes una pregunta clínica que nuestra Unidad de Síntesis y Transferencia del Conocimiento pueda resolver a través de evidencia científica?

Sí, enviar pregunta

Referencias

Owens CD, Stoessel K. Surgical site infections: epidemiology, microbiology and prevention. Journal of Hospital Infection. 2008 Nov 1;70(SUPPL. 2):3–10.

Mengistu D, Alemu A, Abdukadir A, Husen A, Ahmed F, Mohammed B, et al. Global Incidence of Surgical Site Infection Among Patients: Systematic Review and Meta-Analysis. Inquiry [Internet]. 2023 [cited 2023 Dec 14];60:1–11. Available from: https://pubmed.ncbi.nlm.nih.gov/36964747/

Monahan Id M, Jowett Id S, Pinkney Id T, Brocklehurst P, Morton DG, Abdali Z, et al. Surgical site infection and costs in low- and middle-income countries: A systematic review of the economic burden. 2020 [cited 2024 Jan 11]; Available from: https://doi.org/10.1371/journal.pone.0232960

Badia JM, Casey AL, Petrosillo N, Hudson PM, Mitchell SA, Crosby C. Impact of surgical site infection on healthcare costs and patient outcomes: a systematic review in six European countries. Journal of Hospital Infection [Internet]. 2017 [cited 2023 Dec 14];96:1–15. Available from: www.sciencedirect.com

Ukhsa. Protocol for the Surveillance of Surgical Site Infection.

Horgan S, Saab MM, Drennan J, Keane D, Hegarty J. Healthcare professionals’ knowledge and attitudes of surgical site infection and surveillance: A narrative systematic review. Nurse Educ Pract. 2023 May 1;69:103637.

Russo PL, Saguil E, Chakravarthy M, Lee KY, Ling ML, Morikane K, et al. Improving surgical site infection prevention in Asia-Pacific through appropriate surveillance programs: Challenges and recommendation. Infect Dis Health. 2021 Aug 1;26(3):198–207.

Connolly A, Kirwan M, Matthews A. Validation of the rates of adverse event incidence in administrative healthcare data through patient chart review: A scoping review protocol. HRB Open Research 2023 6:21 [Internet]. 2023 Mar 23 [cited 2023 Dec 18];6:21. Available from: https://hrbopenresearch.org/articles/6-21

Kim J, Choi EY, Lee W, Oh HM, Pyo J, Ock M, et al. Feasibility of Capturing Adverse Events From Insurance Claims Data Using International Classification of Diseases, Tenth Revision, Codes Coupled to Present on Admission Indicators. J Patient Saf [Internet]. 2022 Aug 1 [cited 2023 Dec 18];18(5):404. Available from: /pmc/articles/PMC9329045/

Rodrigo-Rincon I, Martin-Vizcaino MP, Tirapu-Leon B, Zabalza-Lopez P, Abad-Vicente FJ, Merino-Peralta A. Validity of the clinical and administrative databases in detecting post-operative adverse events. International Journal for Quality in Health Care [Internet]. 2015 Aug 1 [cited 2023 Dec 18];27(4):267–75. Available from: https://dx.doi.org/10.1093/intqhc/mzv039

Storesund A, Haugen AS, Hjortås M, Nortvedt MW, Flaatten H, Eide GE, et al. Accuracy of surgical complication rate estimation using ICD-10 codes. British Journal of Surgery [Internet]. 2019 Feb 6 [cited 2023 Dec 14];106(3):236–44. Available from: https://dx.doi.org/10.1002/bjs.10985

Sheikh H, Prins C, Schrijvers E. Mission AI: The New System Technology. Springer Nature; 2023.

Irgang L, Barth H, Holmén M. Data-Driven Technologies as Enablers for Value Creation in the Prevention of Surgical Site Infections: a Systematic Review. J Healthc Inform Res [Internet]. 2023 Mar 1 [cited 2024 Jan 12];7(1):1. Available from: /pmc/articles/PMC9995622/

MEDLINE. Systematic Reviews Filter Strategy [Internet]. 2019 [cited 2023 Dec 13]. Available from: https://www.nlm.nih.gov/bsd/pubmed_subsets/sysreviews_strategy.html

Wu G, Khair S, Yang F, Cheligeer C, Southern D, Zhang Z, et al. Performance of machine learning algorithms for surgical site infection case detection and prediction: A systematic review and meta-analysis. Ann Med Surg (Lond) [Internet]. 2022 Dec 1 [cited 2023 Dec 14];84. Available from: https://pubmed.ncbi.nlm.nih.gov/36582918/

Fletcher RR, Olubeko O, Sonthalia H, Kateera F, Nkurunziza T, Ashby JL, et al. Application of Machine Learning to Prediction of Surgical Site Infection. Conf Proc IEEE Eng Med Biol Soc. 2019 Jul 1;2019:2234–7.

Shea BJ, Reeves BC, Wells G, Thuku M, Hamel C, Moran J, et al. AMSTAR 2: a critical appraisal tool for systematic reviews that include randomised or non-randomised studies of healthcare interventions, or both. BMJ [Internet]. 2017 Sep 21 [cited 2023 Dec 18];358:4008. Available from: https://www.bmj.com/content/358/bmj.j4008

Andrews J, Guyatt G, Oxman A, Alderson P, Dahm P, Falck-Ytter Y, et al. GRADE : going from evidence to recommendations: the significance and presentation of recomendations. Journal of LCinical Epidemiology. 2013;66:719–25.

Dinnes J, Deeks J, Kirby J, Roderick P. A methodological review of how heterogeneity has been examined in systematic reviews of diagnostic test accuracy HTA Health Technology Assessment NHS R&D HTA Programme. Health Technol Assess (Rockv) [Internet]. 2005;9(12). Available from: http://www.ncchta.org